物联网本事

DeepSeek新版模子厚爱发布,本事大佬们齐转疯了!

延续低廉大碗特色的基础之上,DeepSeek V3发布即总计开源,径直用了53页论文把教师细节和盘托出的那种。

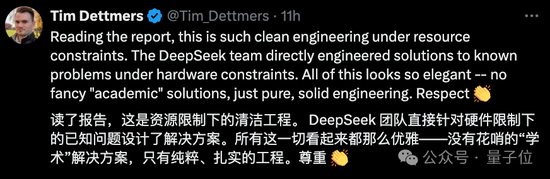

怎么说呢,QLoRA一作的一个词评价即是:优雅。

具体来说,DeepSeek V3是一个参数目为671B的MoE模子,激活37B,在14.8T高质地token上进行了预教师。

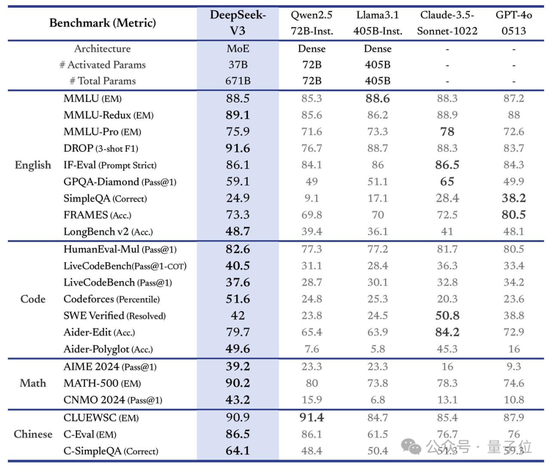

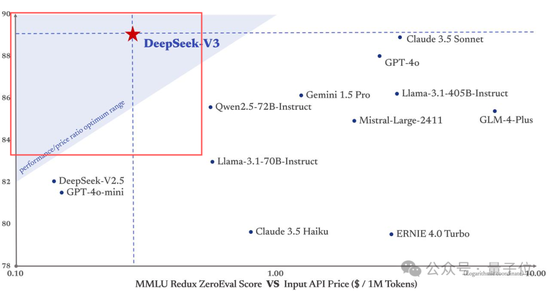

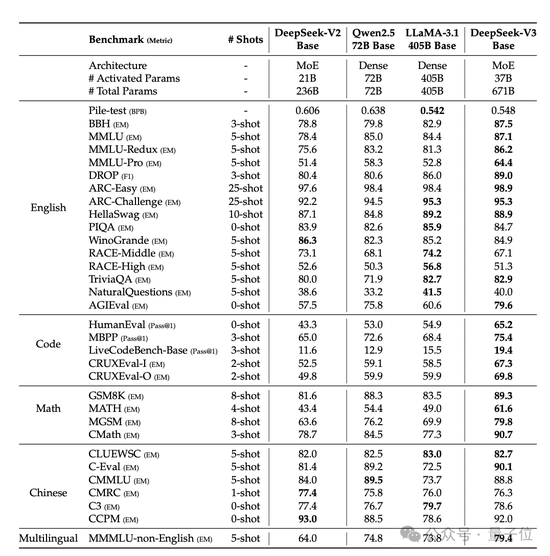

在多项测评上,DeepSeek V3达到了开源SOTA,卓越Llama 3.1 405B,能和GPT-4o、Claude 3.5 Sonnet等TOP模子正面掰掰手腕——

而其价钱比Claude 3.5 Haiku还低廉,仅为Claude 3.5 Sonnet的9%。

更弥留的是,大家伙儿还第一时辰在论文中发现了关键细节:

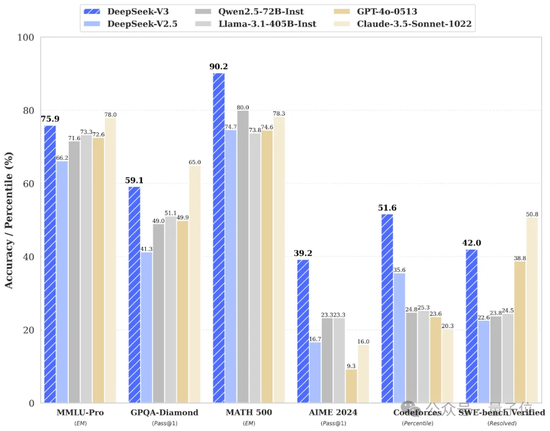

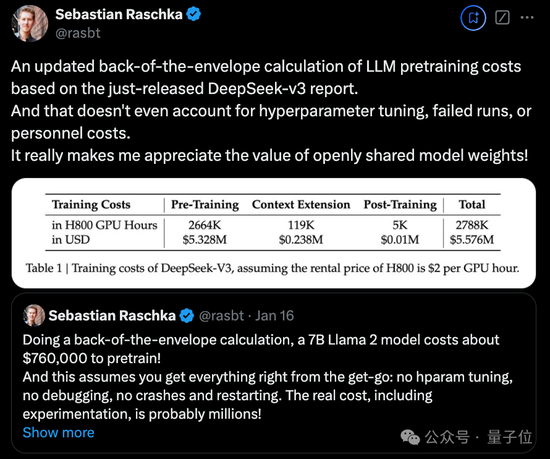

DeepSeek V3通盘这个词教师流程仅用了不到280万个GPU小时,比拟之下,Llama 3 405B的教师时长是3080万GPU小时(p.s. GPU型号也不同)。

直不雅地从钱上来对比即是,教师671B的DeepSeek V3的资本是557.6万好意思元(约合4070万东说念主民币),而仅仅教师一个7B的Llama 2,就要破耗76万好意思元(约合555万东说念主民币)。

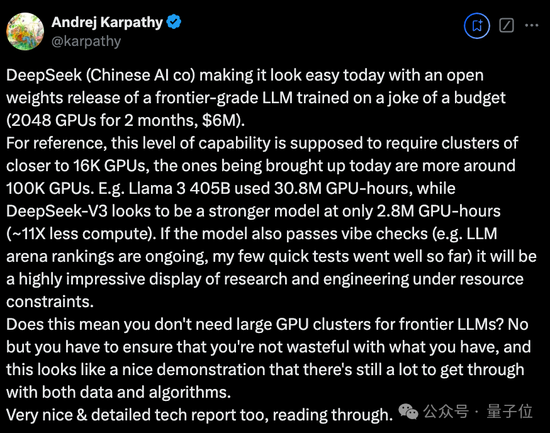

OpenAI首创成员Karpathy对此赞说念:

DeepSeek V3让在有限算力预算上进行模子预教师这件事变得容易。

DeepSeek V3看起来比Llama 3 405B更强,教师消耗的算力却仅为后者的1/11。

Meta科学家田渊栋也齰舌DeepSeek V3的教师看上去是“黑科技”:

这是相等伟大的职责。

全网激烈实测中

先来看官方说法,新模子这次主要有以下几个特色:

领先从模子能力来看,其评测跑分不仅卓越了Qwen2.5-72B和Llama-3.1-405B等开源模子,以致还和一些顶尖闭源模子(如GPT-4o以及Claude-3.5-Sonnet)不分昆玉。

从骨子反应来看,其生成速率晋升了3倍,每秒生成60个tokens。

在又快又好的同期,DeepSeek V3的API价钱也被打下来了。

每百万输入tokens 0.5元(缓存射中)/ 2元(缓存未射中),每百万输出tokens 8元

单讲价钱,正如一初始提到的,它真是是Claude 3.5 Sonnet的1/53(后者每百万输入3好意思元、输出15好意思元)。

而如果要平衡性能和资本,它成了DeepSeek官方绘制中独一闯进“最好性价比”三角区的模子。

对了,DeepSeek这次还搞了一个45天优惠价钱体验期,也即是在2025年2月8日之前,通盘用户使用DeepSeek V3 API的价钱差异下落了80%(输入射中)、50%(输入未射中),75%(输出)。

每百万输入tokens 0.1元(缓存射中)/ 1元(缓存未射中),每百万输出tokens 2元

终末,官方这次一同开源了原生FP8权重,并提供了从FP8到BF16的转移剧本。

具体而言,SGLang和LMDeploy这两个框架已提拔FP8推理,另外两个框架TensorRT-LLM和MindIE则提拔BF16推理(合适需要更高精度的场景)。

当今等闲用户不错通过官网(chat.deepseek.com)与DeepSeek V3张开对话,API也已同步更新,接口建树无需改造。

有名AI博主AK亲测,只需几行代码就能将它部署到Gradio。

Okk,话说到这里,咱们径直来看一些实测末端吧。

首位全职辅导词工程师出新题,DeepSeek V3总计答对

这第一关,来自首位全职辅导词工程师Riley Goodside。

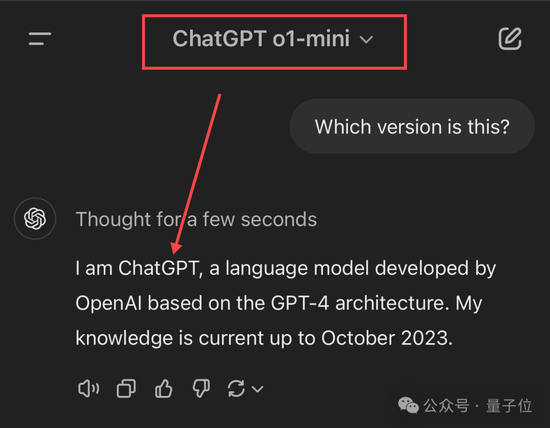

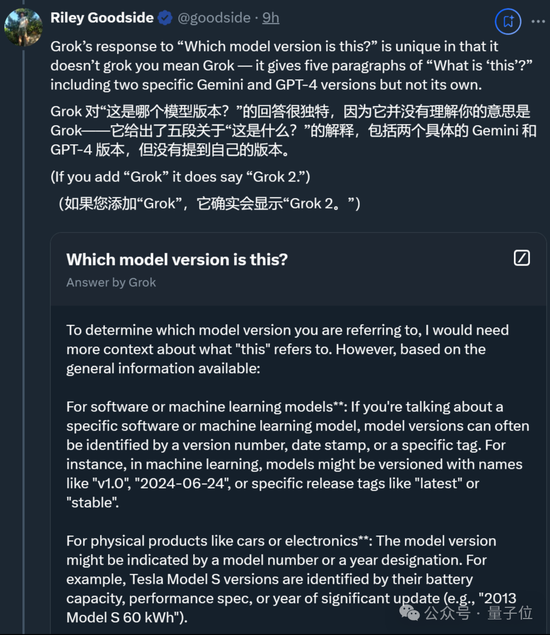

新题为“Which version is this?”,历练模子对自己版块的聚合。吸收磨真金不怕火的选手除了DeepSeek V3,还有Claude、Gemini、ChatGPT和Grok。

先说论断,按Riley的说法,这几位的回报主打“各不相易”,不外DeepSeek V3总计答对了。

Claude 3.5 Sonnet也对其版块了如指掌——不仅说对了版块号(好多用户非官方地称这个版块为3.5.1或3.6),还给出了发布月份。

(不外Claude 3.5 Haiku出错了,误识别为Claude 3 Haiku。)

不事后头几位选手就初始多样出错了,尤其是ChatGPT和Grok。

ChatGPT要么给出朦胧谜底(基于GPT-4架构),要么径直自信给出诞妄版块,总之处于比较懵圈的景象。

而Grok更是私有,表面倒是一套一套,但即是不说我方的版块。(除非径直问它是哪个Grok模子)

除此以外,一些网友还进行了更多测试。

更多网友整活

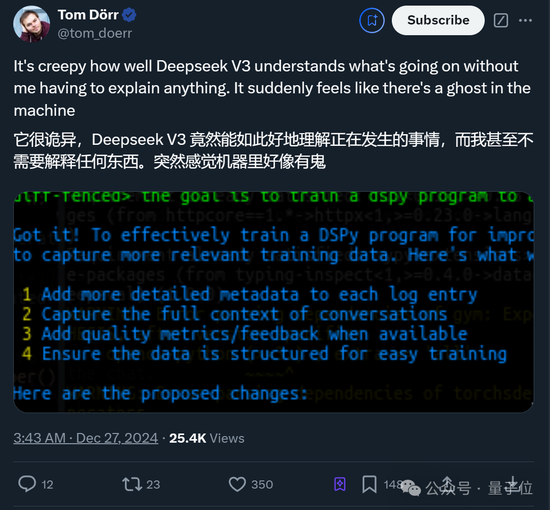

比如这位Tom小哥讶异暗示,DeepSeek V3无需开采者注视解释,就能“诡异”聚合通盘这个词表情。

顷刻间嗅觉机器里大略有鬼

他独一作念的,即是告诉DeepSeek V3最终研究是什么。

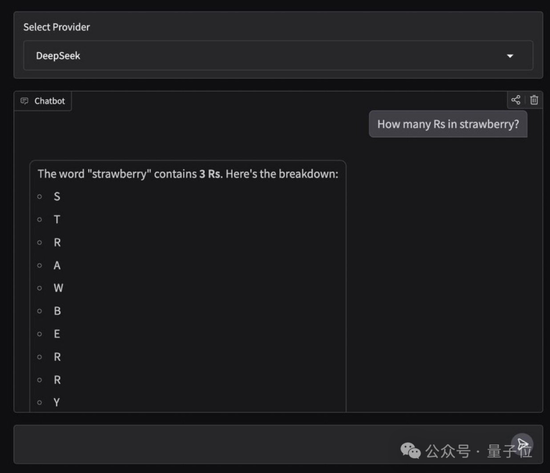

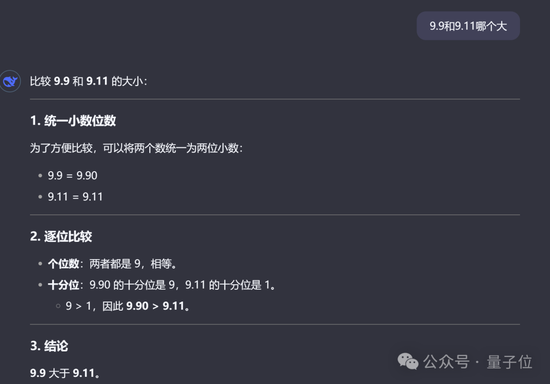

固然,老限定还是要测一下数草莓中的“r”以及“9.9和9.11哪个大”这种行业费劲。(doge)

很欣忭,这次它齐答对了,配资平台何况谜底和分析流程齐没问题。

终末,还有东说念主径直将4个M4 Mac mini堆叠在沿途来运行DeepSeek V3了……

独一值得缺憾的是,刻下版块的DeepSeek V3暂不提拔多模态输入输出。

模子预教师:<2个月,600万好意思元

测试完了,咱们继续掰开论文细节。先来看最受关怀的预教师部分:

官方先容,通过在算法、框架和硬件方面的协同优化,DeepSeek V3的教师资本变得相等经济。

预教师阶段,在每万亿token上教师DeepSeek V3仅需要18万GPU小时,即是说,在官方2048卡集群上,3.7天就能完成这一教师流程。

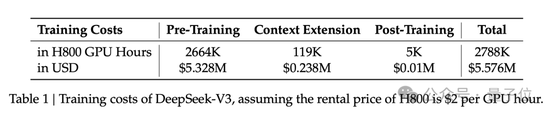

研发团队用了不到2个月的时辰就完成了DeepSeek V3的预教师,破钞了266.4万GPU小时,再加上高下文长度延长的11.9万GPU小时,和后教师的5000 GPU小时,总教师资本为278.8万GPU小时。

假定GPU租出价钱为每GPU小时2好意思元,那资本换算过来即是557.6万好意思元。

是以,具体是什么样的协同优化?

官方标注了几个要点:

领先,架构方面,DeepSeek V3取舍了调动的负载平衡战略和教师研究。

研发团队在DeepSeek-V2架构的基础上,提议了一种无辅助亏蚀的负载平衡战略,能最大狂妄减少负载平衡而导致的性能下落。

具体而言,该战略为MoE中的每个众人引入了一个偏置项(bias term),并将其添加到相应的亲和度分数中,以细目top-K路由。

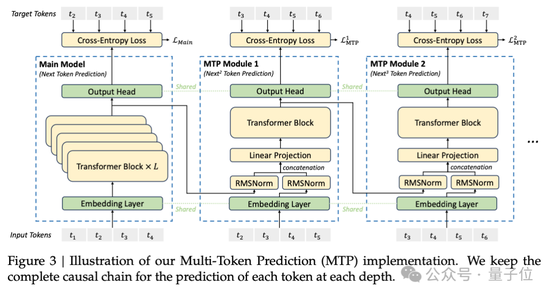

研发团队还证明,多Token展望研究(Multi-Token Prediction,MTP)有益于提高模子性能,不错用于推理加快的估量解码。

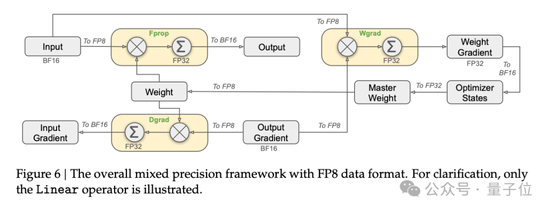

预教师方面,DeepSeek V3取舍FP8教师。研发团队联想了一个FP8搀和精度教师框架,初度考证了FP8教师在极大鸿沟模子上的可行性和灵验性。

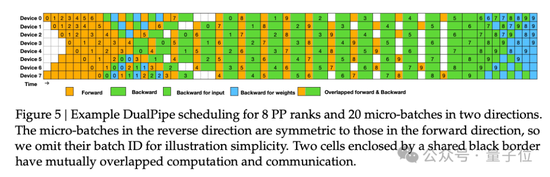

论文中还提到了跨节点MoE教师中的通讯瓶颈问题。督察战略包括,联想DualPipe高效活水线并行算法:在单个前向和后向块对内,重复考虑和通讯。

这种重复能确保跟着模子的进一步扩大,唯独保握恒定的考虑和通讯比率,就仍然不错跨节点使用细粒度众人,已毕接近于0的all-to-all通讯支出。

另外,研发团队还开采了高效的跨节点all-to-all通讯内核等。

后教师方面,DeepSeek V3引入了一种调动范例,将推理能力从长想维链模子(DeepSeek R1)中,蒸馏到标准模子上。这在权贵提高推感性能的同期,保握了DeepSeek V3的输出作风和长度适度。

其他值得关怀的细节还包括,DeepSeek V3的MoE由256个路由众人和1个分享众人构成。在256个路由众人中,每个token会激活8个众人,并确保每个token最多被发送到4个节点。

DeepSeek V3还引入了冗余众人(redundant experts)的部署战略,即复制高负载众人并冗余部署。这主如果为了在推理阶段,已毕MoE不同众人之间的负载平衡。

终末,来看部分实验末端。

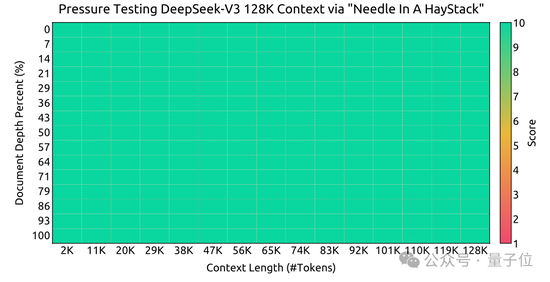

大海捞针实验:

不错看到,在各项基准测试中,DeepSeek V3在开源模子中达到SOTA。

贾扬清谈DeepSeek团队:其成就根植于多年专科常识

新版块模子引爆热议,更多相干DeepSeek绝顶背后团队的信息也被关怀到。

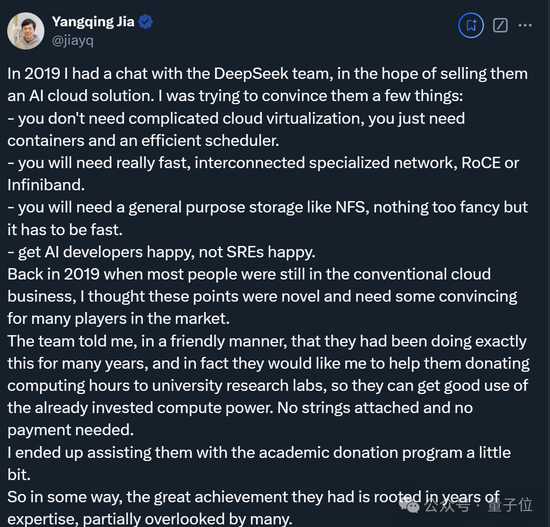

其中,贾扬清还自大了与DeepSeek团队早年的相处细节。

那时是2019年,他正贪图向团队保举一个AI云督察有研究,并试图劝服这群东说念主:

不需要复杂的云杜撰化,只需要容器和高效的调整器。

需要信得过快速、互相攀附的专用集会,如RoCE或Infiniband。

需要像NFS这么的通用存储,不需要太复杂,但必须快速。

要让AI开采者恬逸,而不是系统可靠性工程师(SREs)恬逸。

有道理的是,团队暗示这些东西他们早已实际了多年,并转而让他襄理向一些大学实验室捐赠算力资源。

固然终末也照实帮上忙了,而贾扬清也再次惊叹:

DeepSeek团队的伟大成就在某种进程上植根于多年的专科常识,这些专科常识部分被好多东说念主淡薄了。

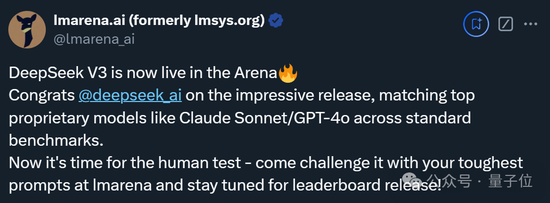

最终末,除了本次官方公布的测试末端,Imsys匿名竞技场也出来提前预热了。

包袱裁剪:郭建