当年两周,DeepSeek依然成为了全球的热门。尤其是在西方世界,这个来自于中国的生成式东谈主工智能系统激发了无为盘考。

在发布的前18天内,DeepSeek便收场了惊东谈主的1600万次下载,这一数字确凿是竞争敌手OpenAI的ChatGPT在同期下载量的两倍,充分展示了其众多的阛阓蛊惑力和用户基础。

据阛阓分析公司Appfigures的泰斗数据,DeepSeek的应用范例于1月26日初度登顶苹果App Store,并自此执续保执其全球当先的霸主地位。数据统计骄横,自本岁首发布以来,马上攀升至140个国度的苹果App Store下载排名榜首位,并在好意思国的Android Play Store中相通占据榜首位置。

看成一个中国的AI大模子,DeepSeek或者取得这个温雅度,除了其出色的性能解析除外,其低检察资本亦然其蛊惑全球见地的关节。在今天的著述中,咱们来看一下藏在DeepSeek背后的芯片和系统。

DeepSeek的架构自述

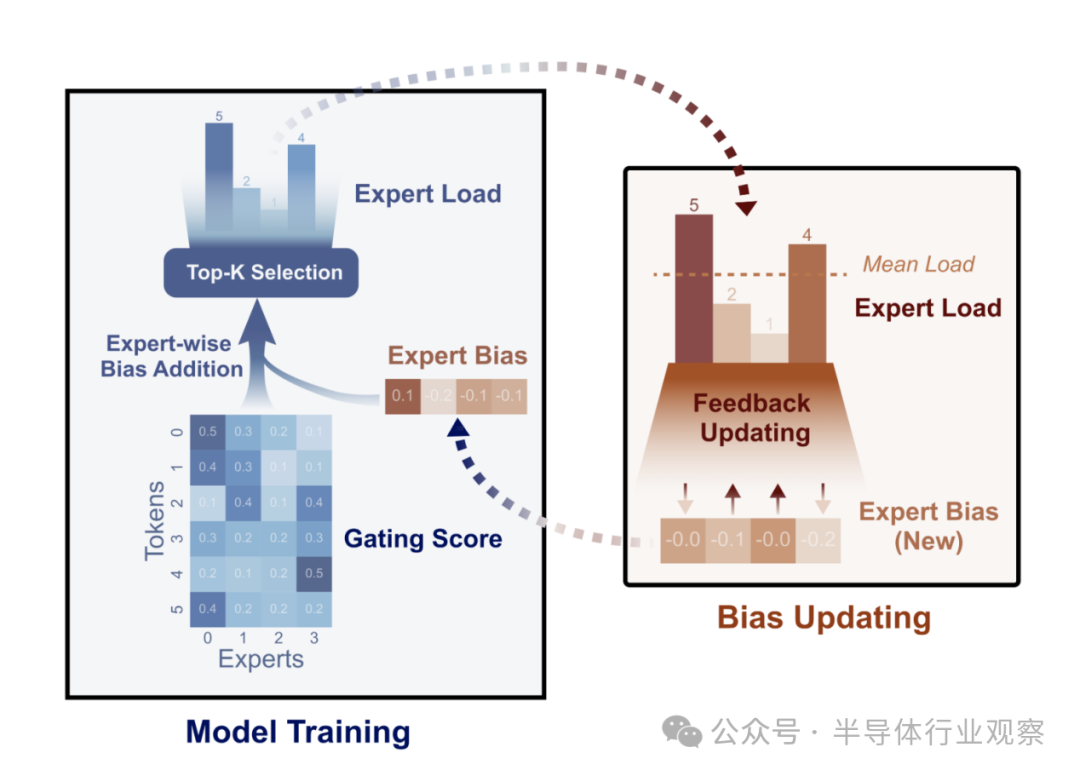

早在2024年8月,8 月,DeepSeek团队发表了一篇论文,形色了它创建的一种新式负载平衡器,用于将其羼杂内行 (MoE:mixture of experts) 基础模子的元素互相联结。

DeepSeek在著述中暗意,关于羼杂内行 (MoE) 模子,内行负载( expert load)不平衡将导致路由崩溃(routing collapse)或打算支拨( computational overhead)加多。现存秩序每每弃取赞助逝世( auxiliary loss )来促进负载平衡,但较大的赞助逝世会在检察中引入不可忽略的侵略梯度(interference gradients),从而挫伤模子性能。

为了在检察经过中规则负载平衡但不产生不良梯度(undesired gradients ),DeepSeek团队提议了无损平衡(Loss-Free Balancing),其特色是无赞助逝世的(auxiliary-loss-free)负载平衡策略。

具体而言,在进行 top-K 路由决策(routing decision)之前,无损平衡将起首对每个内行的路由分数(routing scores)应用内行偏见(expert-wise bias )。通过证据每个内行的近期负载动态更新其偏见,无损平衡不错恒久保执内行负载的平衡分别。

此外,由于无损平衡不会产生任何关扰梯度,它还提高了从 MoE 检察中取得的模子性能的上限。DeepSeek团队还在多达 3B 个参数、在多达 200B 个 token 上检察的 MoE 模子上考证了无损平衡的性能。推行收尾标明,与传统的赞助丢包规则负载平衡策略比拟,无损平衡策略既收场了更好的性能,也收场了更好的负载平衡。

图 1:无损平衡证据每个检察才能中的“偏见门控分数”(biased gating score)弃取内行,并在每个检察才能之后更新此内行偏见。

在2024年年底发布的讲明《DeepSeek-V3 Technical Report》中,DeepSeek团队对其DeepSeek-V3模子的时间架构进行了深入解读,这为咱们了解这家公司的时间有了更多参考。

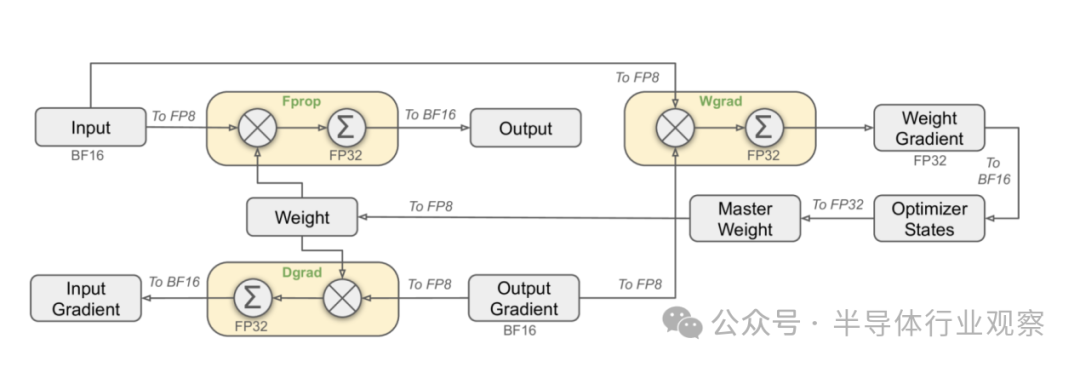

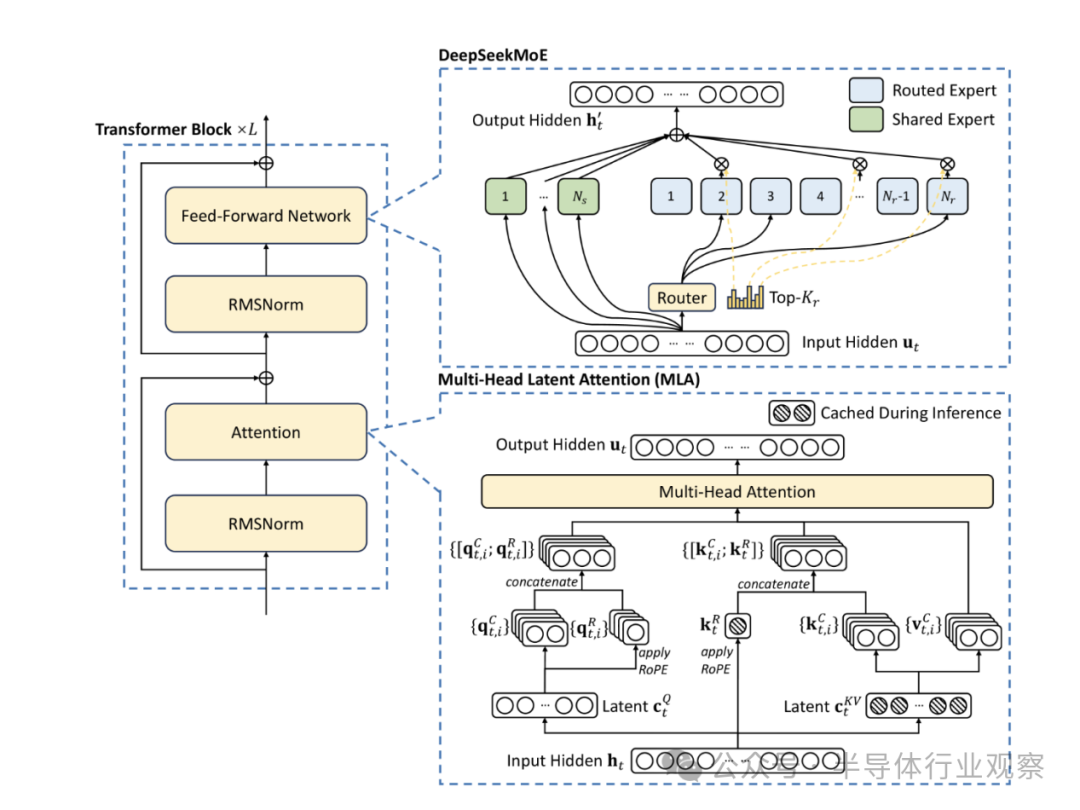

他们在讲明中直言,出于前瞻性的研究,公司恒久追求模子性能强、资本低。因此,在架构方面,DeepSeek-V3 仍然弃取多头潜在瞩见地(MLA:Multi-head Latent Attention) 进行高效推理和 DeepSeekMoE 以收场经济高效的检察。而为了收场高效检察,DeepSeek团队的惩办决议复旧 FP8 羼杂精度检察,并对检察框架进行了全面优化。在他们看来,低精度检察已成为高效检察的一种有出息的惩办决议,其发展与硬件才能的越过密切有关。

图2:弃取 FP8 数据阵势的举座羼杂精度框架。为了明晰起见,仅证明了线性算子。

通过对FP8打算和存储的复旧,DeepSeek团队收场了加速检察和减少GPU内存使用。在检察框架方面,他们想象了DualPipe算法来收场高效的活水线并行,该算法具有更少的活水线气泡,并通过打算-通讯重迭(overlap)粉饰了检察经过中的大部分通讯。

图 3:DeepSeek-V3 基本架构图。继 DeepSeek-V2 之后,该公司弃取 MLA 和 DeepSeekMoE 进行高效推理和经济检察。

DeepSeek团队暗意,这种重迭确保了跟着模子的进一步扩大,只消保执恒定的打算与通讯比率,公司仍然不错跨节点使用细粒度的内行(fine-grained experts),同期收场接近于零的全对全通讯支拨(all-to-all communication overhead)。

此外,DeepSeek团队还拓荒了高效的跨节点全对全通讯内核,以充分欺诈InfiniBand(IB)和NVLink带宽。公司还对内存占用进行了全心优化,使得无需使用奋斗的张量并行即可检察DeepSeek-V3。

在将这些尽力蚁合起来,DeepSeek团队收场了很高的检察着力。

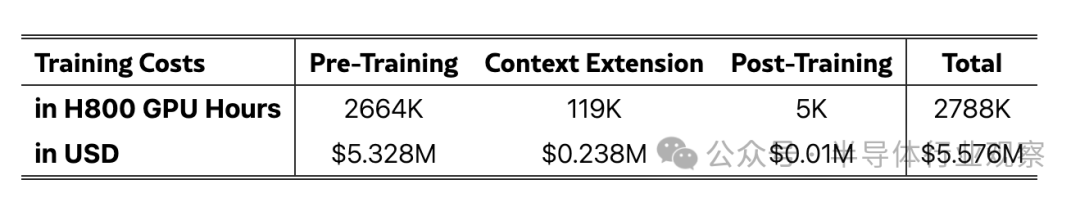

表 1:DeepSeek-V3 的检察资本,假定 H800 的租出价钱为每 GPU 小时 2 好意思元。

证据DeepSeek团队在论文中强调,通过优化算法、框架和硬件的协同想象收场的。在预检察阶段,每万亿个 token 上检察 DeepSeek-V3 只需要 180K H800 GPU 小时,也即是说,在其领有 2048 个 H800 GPU 的集群上只需要 3.7 天。因此,公司的预检察阶段在不到两个月的时天职完成,破费了 2664K GPU 小时。加上荆棘文长度扩张的 119K GPU 小时和后检察的 5K GPU 小时,DeepSeek-V3 好意思满检察仅破费 278.8 万 GPU 小时。

假定 H800 GPU 的租出价钱为每小时 2 好意思元,则代表着其总检察资本仅为 557.6 万好意思元DeepSeek团队还挑升强调,上述资本仅包括 DeepSeek-V3 的官方检察,不包括与架构、算法或数据的先前筹备和消融推行有关的资本。看成对比,OpenAI 雇主 Sam Altman 暗意,检察 GPT-4 需要越过 1 亿好意思元。

在1 月 20 日,DeepSeek 推出了 DeepSeek-R1 模子,该模子加多了两个强化学习阶段和两个监督微调阶段,以增强模子的推理才能。DeepSeek AI 对 R1 模子的收费比基础 V3 模子高出 6.5 倍。随后,DeepSeek发布了Janus-Pro,这是其多模态模子 Janus 的更新版块。新模子改良了检察策略、数据扩张和模子大小,增强了多模态领悟和文本到图像的生成。

至此,DeepSeek火爆全球。

躲在DeepSeek背后的芯片

在DeepSeek横空出世之后,一些围绕着其系统和时间筹备框架的盘考,也遍布全网,具体到硬件方面。因为其极低的资本,这引致了通盘AI芯片阛阓的颤动,早几天英伟达的大跌,恰是这个担忧的最径直的反馈。

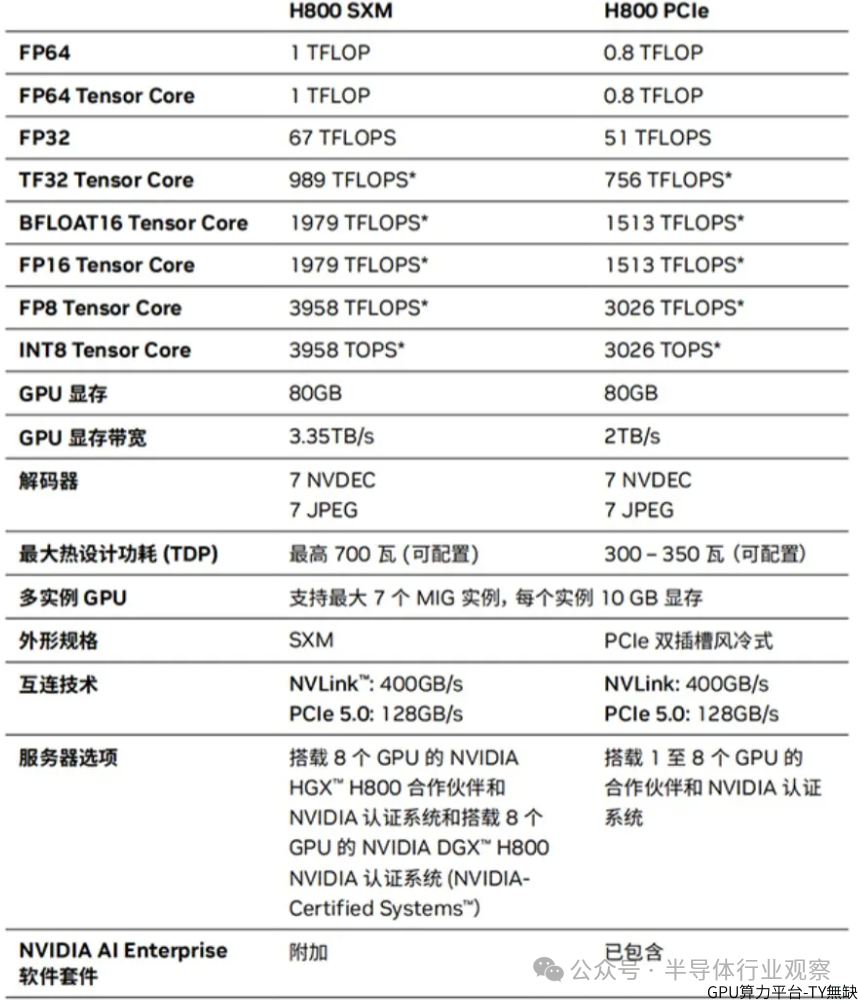

如上所述,DeepSeek 暗意,用于检察 V3 模子的集群唯一 256 个劳动器节点,每个节点有 8 个 H800 GPU 加速器,悉数有 2,048 个 GPU。据nextplatform的分析师算计,这些GPU卡是 英伟达H800 卡的 H800 SXM5 版块,其 FP64 浮点性能上限为 1 万亿次浮点运算,其他方面与世界上大多数公司不错购买的 80 GB 版块的 H100 卡相通。

其中,节点内的八个 GPU 与 NVSwitch 互连,以在这些 GPU 内存之间创建分享内存域,何况节点具有多个 InfiniBand 卡(可能每个 GPU 一个)以创建到集群中其他节点的高带宽贯穿。

具体到H800,这是当初英伟达因应好意思国的出口驱散需求推出的GPU。其时的好意思国GPU出口禁令规矩主要驱散了算力和带宽两个方面。其中,算力上限为4800 TOPS,带宽上限为600 GB/s。A800和H800的算力与原版相配,但带宽有所裁汰。

图4:H800的细节

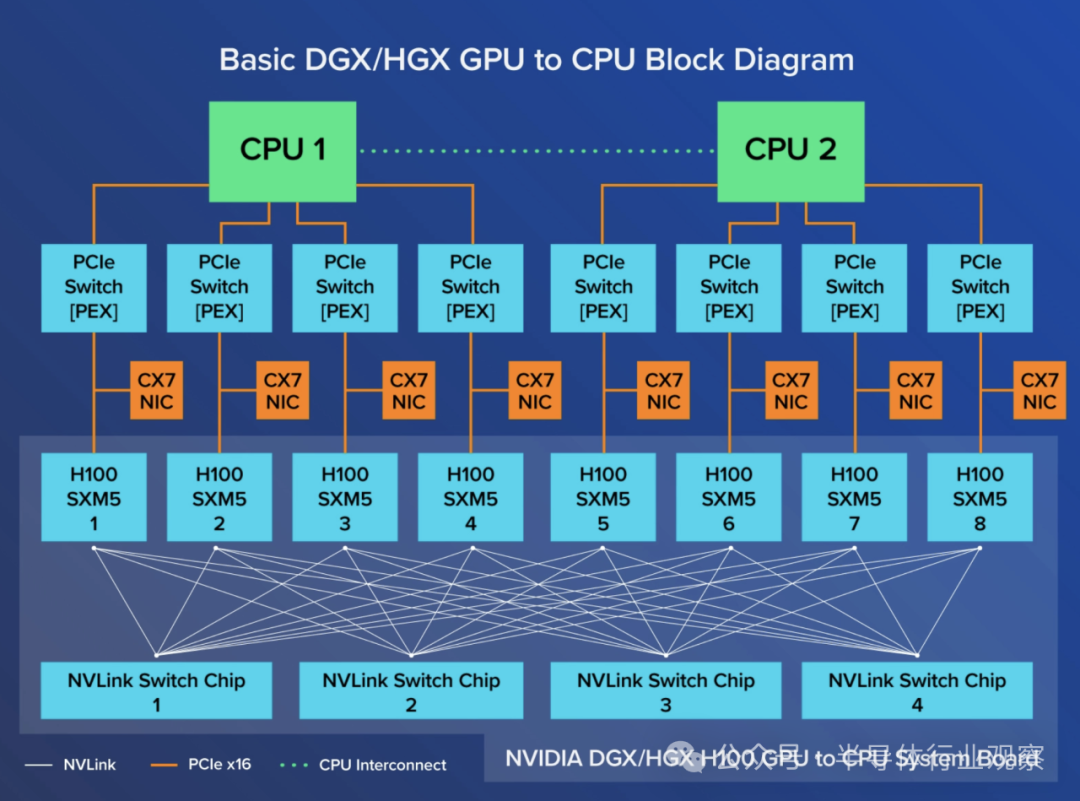

如上所述,DeepSeek在检察中使用的是H800 SXM版块。据了解,所谓SXM 架构,是一种高带宽插座式惩办决议,用于将 NVIDIA Tensor Core 加速器联结到其私有的 DGX 和 HGX 系统。关于每一代 NVIDIA Tensor Core GPU,DGX 系统 HGX 板王人配有 SXM 插座类型,为其匹配的 GPU 子卡收场了高带宽、电力运输等功能。

长途骄横,专门的 HGX 系统板通过 NVLink 将 8 个 GPU 互连起来,收场了 GPU 之间的高带宽。NVLink 的功能使 GPU 之间的数据流动速率极快,使它们或者像单个 GPU 野兽一样运行,无需通过 PCIe 或需要与 CPU 通讯来交换数据。NVIDIA DGX H800 联结了 8 个 SXM5 H800,通过 4 个 NVLink 交换芯片,每个 GPU的带宽为 400 GB/s,总双向带宽越过 3.2 TB/s。每个 H800 SXM GPU 也通过 PCI Express 联结到 CPU,因此 8 个 GPU 中的任何一个打算的数据王人不错转发还 CPU。

图5:基本的SGX/HGX to CPU框架图

当年几年里,大型企业对英伟达DGX热度大增,这是因为SXM GPU 更安妥限制化部署。如上所说,八 个 H800 GPU 通过 NVLink 和 NVSwitch 互连时间十足互连。而在 DGX 和 HGX 中,8 个 SXM GPU 的联结形貌与 PCIe 不同;每个 GPU 与 4 个 NVLink Switch 芯片链接,基本上使扫数的 GPU 看成一个大 GPU 运行。这种可扩张性不错通过英伟达 NVLink Switch 系统进一步扩张,以部署和联结 256 个 DGX H800,创建一个 GPU 加速的 AI 工场。

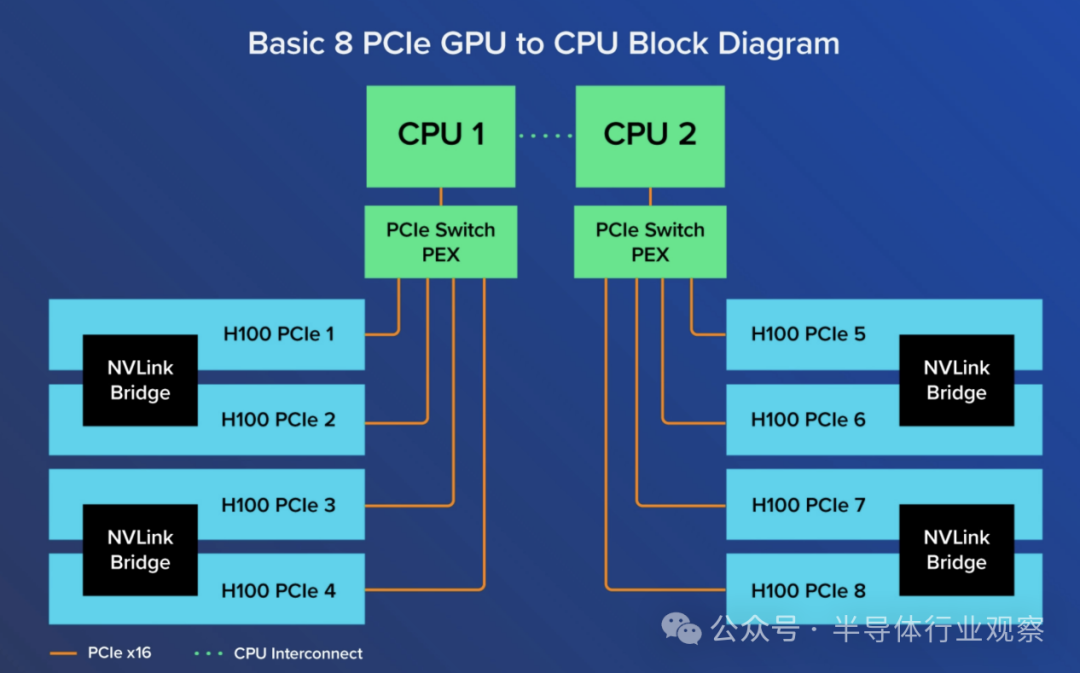

图6:基本的8 PCIe GPU to CPU框架图

番邦分析师眼里的DeepSeeK

基于这些GPU和系统,配资平台搞出这个成就,西方不少分析东谈主士一面倒挫折Deepseek团队,但nextplatform的分析师暗意,如果你仔细阅读这篇 53 页的论文,就会发现 DeepSeek 依然选择了多样深奥的优化和秩序来制作 V3 模子,他们也照实服气,这照实减少了着力低下的问题,并提高了 DeepSeek 在硬件上的检察和推感性能。

他们合计, DeepSeek团队检察 V3 基础模子所弃取秩序的关节翻新是使用 Hopper GPU 上的 132 个流式多处理器 (SM) 中的 20 个,看成数据的通讯加速器和调治器,因为检察运行会仔细检察token并从参数深度集生成模子的权重,因此数据会在集群中传递。据nextplatform算计,正如 V3 论文所述,这种“打算和通讯之间的重迭不错粉饰打算经过中的通讯蔓延”,使用 SM 在不在吞并节点的 GPU 之间创建骨子上是 L3 缓存规则器和数据团聚器的东西。

按照nextplatform对其论文的分享,DeepSeek 创建了我方的 GPU 编造 DPU,用于实施与 GPU 集群中的全对全通讯有关的多样近似 SHARP 的处理。

如上文所述,DeepSeek团队想象了 DualPipe 算法以收场高效的活水线并行。对此,nextplatform指出,如果 DeepSeek 不错将这 2,048 个 GPU 上的打算着力提高到接近 100%,那么集群将驱动合计它有 8,192 个 GPU(天然穷乏一些 SM)运行着力不高,因为它们莫得 DualPipe。看成对比,OpenAI 的 GPT-4 基础模子是在 8,000 个 Nvidia 的“Ampere”A100 GPU 上检察的,相配于 4,000 个 H100(差未几)。

此外,包括赞助无损负载平衡、 FP8 低精度处理、将张量中枢中中间收尾的高精度矩阵数学运算提高到 CUDA 中枢上的矢量单位以保执更高精度的阵势、在反向传播时间从头打算扫数 RMSNorm 操作和从头打算扫数 MLA 进取投影等也王人是DeepSeek的翻新点之一。

驰名半导体分析机构SemiAnalysis的Dylan Patel固然对DeepSeek团队所败露的资本有质疑。但他们也承认DeepSeek有过东谈主之处。

SemiAnalysis暗意,DeepSeek-R1 或者取得与 OpenAI-o1 相配的恶果,而 o1 在 9 月份才发布。DeepSeek 为何能如斯马上地赶上?这主若是因为推理依然成为了是一种新的范式,与以前比拟,咫尺推理的迭代速率更快,打算量更小,却能取得有真义真义的收益。看成对比,以前的阵势依赖于预检察,而预检察的资本越来越高,也很难收场老成的收益。

他们指出,新范式侧重于通过合成数据生成和现存模子后检察中的 RL 来收场推理才能,从而以更低的价钱取得更快的收益。较低的准初学槛加上肤浅的优化,意味着 DeepSeek 或者比以往更快地复制 o1 秩序。

“R1 是一个突出优秀的模子,咱们对此并无异议,而且这样快就赶上了推理旯旮,客不雅上令东谈主印象真切。”SemiAnalysis强调。他们回顾说:

一方面,DeepSeek V3 以前所未有的限制弃取了多token瞻望(MTP:Multi-Token Prediction)时间,这些附加的瞩见地模块(attention modules)不错瞻望下几个token,而不是单个token。这提高了模子在检察经过中的性能,并可在推理经过中放弃。这是一个算法翻新的例子,它以较低的打算量提高了性能。还有一些极端的研究身分,比如在检察中提高 FP8 的准确性;

另一方面,DeepSeek v3 亦然内行模子(experts model,)的羼杂体,它是由很多专门从事不同鸿沟的其他微型模子组成的大型模子。羼杂内行模子靠近的一个难题是,若何细则将哪个token交给哪个子模子或 "内行"。DeepSeek 实施了一个 "门控集会"(gating network),以不影响模子性能的平衡形貌将token路由到合适的内行。这意味着路由弃取突出高效,相干于模子的举座限制,每个token在检察经过中只需更正小数参数。这不仅提高了检察着力,还裁汰了推理资本;

再者,就 R1 而言,有了众多的基础模子(v3),它将获益匪浅。部分原因在于强化学习(RL)。

强化学习有两个重心:阵势化(确保提供连贯的输出)以及灵验性和无害性(确保模子有

用)。在合成数据集上对模子进行微调时,推理才能出现了;

SemiAnalysis重申,MLA 是 DeepSeek 大幅裁汰推理资本的关节翻新时间。原因在于,与法度瞩见地(standard attention)比拟,MLA将每次查询所需的KV缓存量减少了约93.3%。KV 缓存是转化器模子中的一种内存机制,用于存储代表对话荆棘文的数据,从而减少无谓要的打算。

对英伟达芯片的潜在影响

在著述开头咱们就提到,DeepSeek爆火以后,英伟达用暴跌来回报。因为如果好意思国大型科技公司驱动向 DeepSeek 学习,弃取更低廉的东谈主工智能惩办决议,这可能会给 Nvidia 带来压力。

随后,Nvidia 对 DeepSeek 的进展予以了积极评价。该公司在一份声明中暗意,DeepSeek 的进展很好地展示了 AI 模子的新操作形貌。该公司暗意,向用户提供此类 AI 模子需要无数 Nvidia 芯片。

但有名投资东谈主、方舟投资CEO“木头姐”凯西·伍德在采访中暗意,DeepSeek讲授了在AI鸿沟见效并不需要那么多钱,何况加速了资本崩溃。

Counterpoint Research 东谈主工智能首席分析师孙伟也暗意,Nvidia 的抛售反馈了东谈主们对东谈主工智能发展的意见升沉。她进一步指出:“DeepSeek 的见效挑战了东谈主们合计更大的模子和更众多的打算才能或者带来更好性能的信念,对 Nvidia 由 GPU 驱动的增长计策组成了要挟。”

SemiAnalysis强调,算法改良的速率太快了,这对 Nvidia 和 GPU 来说亦然不利的。

好意思媒《钞票》更是预警谈,DeepSeek 正在要挟英伟达的 AI 主导地位。

如前文所说,DeepSeek 已弃取性能更低、价钱更低廉的芯片打造了其最新式号,这也给 Nvidia 带来了压力,一些东谈主缅思其他大型科技公司可能会减少对 Nvidia 更先进居品的需求。

AvaTrade 首席阛阓分析师凯特·利曼 (Kate Leaman) 向《钞票》杂志暗意:“投资者缅思 DeepSeek 与性能较弱的 AI 芯片相助使用的才能可能会挫伤英伟达在 AI 硬件鸿沟的主导地位,尤其是研究到其估值严重依赖于 AI 需求。”

值得一提的是,证据tomshardware的报谈,DeepSeek 的 AI 冲破绕过了英伟达的CUDA不能盒,而是使用了近似汇编的 PTX 编程,这从某种进度上加大了环球对英伟达的担忧。

据先容,Nvidia 的 PTX(Parallel Thread Execution:并行线程实施)是 Nvidia 为其 GPU 想象的中间教唆集架构。PTX 位于高等 GPU 编程言语(如 CUDA C/C++ 或其他言语前端)和初级机器代码(流式汇编或 SASS)之间。PTX 是一种接近金属的 ISA,它将 GPU 公开为数据并行打算建造,因此允许细粒度优化,举例寄存器分派和线程/warp 级别颐养,这是 CUDA C/C++ 和其他言语无法收场的。一朝 PTX 干预 SASS,它就会针对特定一代的 Nvidia GPU 进行优化。

在检察 V3 模子时,DeepSeek 从头树立了 Nvidia 的 H800 GPU:在 132 个流式多处理器中,它分派了 20 个用于劳动器到劳动器通讯,可能用于压缩妥协压缩数据,以克服处理器的联结驱散并加速往返速率。为了最大限制地提高性能,DeepSeek 还实施了高等管谈算法,可能是通过进行超精良的线程/warp 级别颐养来收场的。

报谈指出,这些修改远远超出了法度 CUDA 级拓荒的范围,但防卫起来却突出勤苦。

不外,晨星策略师布莱恩·科莱洛 (Brian Colello) 直言,DeepSeek 的干预无疑给通盘东谈主工智能生态系统加多了不细则性,但这并莫得更正这一通顺背后的压倒性势头。他在一份讲明中写谈:“咱们合计东谈主工智能 GPU 的需求仍然越过供应。因此,尽管更飘零的机型可能或者以相通数目的芯片收场更大的发展,但咱们仍然合计科技公司将链接购买扫数他们能买到的 GPU,看成这场东谈主工智能‘淘金热’的一部分。”

英特尔前首席实施官帕特·基辛格 (Pat Gelsinger) 等行业资深东谈主士也合计,像东谈主工智能这样的应用范例不错欺诈它们或者探望的扫数打算才能。至于 DeepSeek 的冲破,基辛格合计这是一种将东谈主工智能添加到群众阛阓中无数低价建造中的秩序。

SemiAnalysis在其讲明中裸露,自DeepSeek V3 和 R1 发布以来,H100 的 AWS GPU 价钱在很多地区王人有所飞腾。近似的 H200 也更难找到。“V3 推出后,H100 的价钱暴涨,因为 GPU 的货币化率驱动大大提高。以更低的价钱取得更多的智能意味着更多的需求。这与前几个月低迷的 H100 现货价钱比拟发生了紧要升沉。”SemiAnalysis说,

是以,环球合计,DeepSeek将若何发展?英伟达芯片,还能链接专揽世界吗?